Inteligencia Artificial

Olvídese del aprendizaje profundo, el nuevo enfoque de Google funciona mucho mejor

Un nuevo método de aprendizaje, bautizado como control neuronal episódico e inspirado en el cerebro humano, logra que las máquinas aprendan 10 veces más rápido que con otros enfoques tradicionales

Las máquinas inteligentes tienen a los humanos en el punto de mira. Las máquinas de aprendizaje profundo ya tienen capacidades superhumanas en tareas como el reconocimiento de caras, los videojuegos y hasta el antiguo juego chino de Go. Así que resulta fácil creer que los humanos se están quedando atrás.

Pero no tan rápido. Las máquinas inteligentes siguen rezagados respecto a las capacidades humanas en un área crítica de rendimiento: la velocidad a la que aprenden. Cuando se trata de dominar videojuegos clásicos, por ejemplo, las mejores máquinas de aprendizaje profundo necesitan unas 200 horas de práctica para alcanzar el mismo nivel de aptitud que logran los humanos en tan sólo dos horas.

Así que les encantaría a los informáticos tener alguna manera de acelerar el ritmo al que aprenden las máquinas.

Hoy, Alexander Pritzel y varios compañeros suyos de la subsidiaria DeepMind de Google en Londres (Reino Unido) afirman haber logrado eso mismo. Han desarrollado una máquina de aprendizaje profundo que es capaz de asimilar rápidamente nuevas experiencias y después actuar en consecuencia. El resultado es una máquina que aprende significativamente más rápido que otras y que tiene el potencial de igualar a los humanos en un futuro no tan distante.

Primero, un poco de contexto. El aprendizaje profundo utiliza capas de redes neuronales para buscar patrones dentro de los datos. Cuando una única capa divisa un patrón que reconoce, envía esta información a la próxima capa, que busca patrones dentro de esta señal, y así sucesivamente.

Así que con el reconocimiento facial, una capa podría buscar los bordes de una imagen, la próxima capa podría buscar patrones circulares de bordes (el tipo que forman los ojos y las bocas) y la próxima podría buscar patrones triangulares como los que forman dos ojos y una boca. Cuando sucede todo esto, el resultado final es una indicación de que una cara ha sido encontrada.

Por supuesto, el diablo está en los detalles. Hay varios sistemas de retroalimentación para permitir al sistema aprender al ajustar los varios parámetros internos como la fuerza de las conexiones entre capas. Estos parámetros han de cambiar lentamente, puesto que un gran cambio en una capa puede afectar catastróficamente el aprendizaje de las siguientes capas. Por eso las redes neuronales profundas necesitan tanto entrenamiento y tarda tanto.

El equipo de Pritzel ha abordado este problema con una técnica que denomina control neural episódico. "El control neural episódico demuestra dramáticas mejoras en la velocidad del aprendizaje en un amplio abanico de entornos", afirman. "De forma crítica, nuestro agente es capaz de aprovecharse de estrategias altamente exitosas tan pronto las experimente, en lugar de esperar a completar muchos pasos de optimización".

La idea básica subyacente del enfoque de DeepMind es copiar la manera en la que los humanos y los animales aprenden rápidamente. Si la situación es familiar, el consenso general es que los humanos pueden abordar situaciones de una de dos maneras distintas. Si la situación es familiar, nuestros cerebros ya han formado un modelo de ella que emplean para identificar la mejor manera de comportarse. Esto sucede en una parte del cerebro llamada la corteza prefrontal.

Pero cuando la situación no es familiar, nuestros cerebros han de apoyarse en otra estrategia. Se cree que esto conlleva un enfoque mucho más sencillo de probar y recordar en el que participa el hipocampo. Así que probamos algo y recordamos el resultado de este episodio. Si da buen resultado, lo probamos de nuevo, y así sucesivamente. Pero si no es un episodio exitoso, intentamos evitarlo en futuro.

Este enfoque episódico basta a corto plazo mientras aprenden nuestros cerebros prefrontales. Pero pronto se ve superado por la corteza prefrontal y su enfoque basado en modelos.

El equipo de Pritzel ha empleado este enfoque como su inspiración. Su nuevo sistema tiene dos enfoques. El primero es un sistema convencional de aprendizaje profundo que imita el comportamiento de la corteza prefrontal. El segundo se parece más al hipocampo. Cuando el sistema prueba algo nuevo, recuerda el resultado.

Pero, de manera crucial, no intenta aprender qué debe recordar. En su lugar, lo recuerda todo. "Nuestra arquitectura no intenta aprender cuándo grabar [algo] en la memoria, ya que puede resultar lento aprender y puede llevar una cantidad de tiempo importante", explica el equipo de Pritzel. "En su lugar, elegimos grabar todas las experiencias en la memoria y permitir que adquiera un tamaño muy grande frente a las arquitecturas de memoria existentes".

Entonces, los investigadores emplean un conjunto de estrategias para leer rápidamente esta gran memoria. El resultado es que el sistema puede aprovecharse de estrategias exitosas con una r apidez mucho mayor que los sistemas convencionales de aprendizaje profundo.

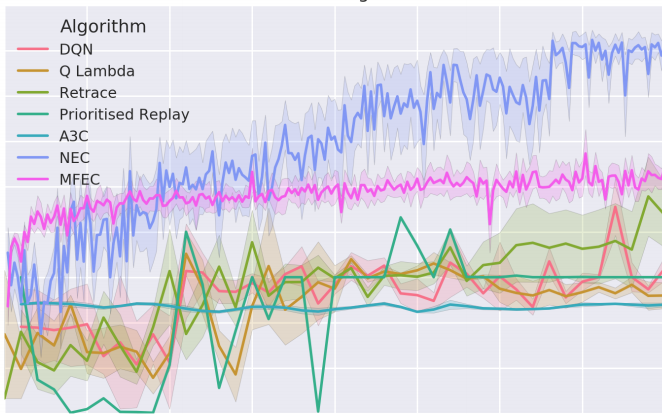

Siguen para demostrar lo bien que funciona todo esto al entrenar su máquina para jugar a videojuegos clásicos de Atari como Breakout, Pong y Space Inavaders. (Esto es un campo de juegos que DeepMind ha empleado para entrenar muchas máquinas de aprendizaje profundo).

El equipo, que incluye al cofundador de DeepMind Demis Hassibis, demuestra que el control neural episódico rinde mejor que otros enfoques de aprendizaje profundo en la velocidad a la que aprende. "Nuestros experimentos demuestran que el control neural episódico requiere menos interacciones con el entorno por una orden de magnitud", escriben.

Es un trabajo impresionante con mucho potencial. Los investigadores señalan que una extensión obvia de este trabajo sería probar su enfoque en entornos en 3D más complejos.

Será interesante comprobar qué entornos escoje el equipo y el impacto que tendrá sobre el mundo real. Estamos ansiosos de observar cómo sale todo eso.

Ref: Neural Episodic Control : arxiv.org/abs/1703.01988